Serviços Personalizados

Artigo

Links relacionados

Compartilhar

RFO UPF

versão impressa ISSN 1413-4012

RFO UPF vol.21 no.1 Passo Fundo Jan./Abr. 2016

Importância da reprodutibilidade dos métodos para diagnóstico em odontologia

Importance of reproducibility of methods for Dentistry diagnosis

Amanda Falcão da Silva I; Marilia Mattar de Amoêdo Campos Velo II; Antônio Carlos Pereira III

I Doutora em Odontologia (área de Cariologia) pela Faculdade de Odontologia de Piracicaba, Unicamp, Piracicaba, São Paulo, Brasil

II Mestra em Cariologia pela Faculdade de Odontologia de Piracicaba, Unicamp, Piracicaba, São Paulo, Brasil

III Professor Doutor Associado do Departamento de Odontologia Preventiva e Saúde Pública, Piracicaba, São Paulo, Brasil

Resumo

Objetivo: reprodutibilidade pode ser definida como a capacidade de concordância dos resultados quando o instrumento é aplicado uniformemente e repetidas vezes sobre objetos invariantes. Assim, o objetivo do presente trabalho foi fazer uma revisão sobre reprodutibilidade dos métodos e instrumentos estatísticos utilizados nos estudos, a fim de obter informações importantes para uma melhor evidência científica. Revisão de literatura: a reprodutibilidade de um método diagnóstico pode ser, facilmente, avaliada, por exemplo, pela repetição independente de exames realizados em determinado número de pacientes, em um intervalo de tempo relativamente curto, garantindo que não haverá mudança na situação da doença, inicialmente avaliada. Os exames podem ser repetidos por um único examinador, no caso da concordância intraexaminador, ou por diferentes examinadores, na concordância interexaminador. Dentre as medidas de reprodutibilidade disponíveis para avaliação de métodos clínicos e epidemiológicos da cárie dentária, destacam-se a porcentagem geral de concordância, a estatística Kappa, o índice Dice e o coeficiente de correlação intraclasse, sendo, de uma maneira geral, instrumentos de extrema importância no sentido de verificar e melhorar a precisão da pesquisa. Considerações finais: o emprego apropriado e bem indicado dos instrumentos de confiabilidade é de grande relevância, pois gera respostas e direcionamentos quanto à capacidade e à precisão do instrumento ou do método utilizado.

Palavras-chave: Diagnóstico. Reprodutibilidade dos testes. Validade dos testes.

Abstract

Objective: Reproducibility may be defined as the ability of agreement of results when the instrument is applied uniformly and repeatedly over invariant objects. Thus, this study aimed to perform a review on the reproducibility of methods and the statistical tools used in the studies, in order to get important information for better scientific evidence. Literature review: The reproducibility of a diagnosis method may be easily assessed, for example, by repeating independent tests performed to a given number of patients in a relatively short time, ensuring there is no change in the status of the disease initially assessed. Tests may be repeated by the same examiner in the case of intra-examiner agreement, or by different examiners for inter-examiner agreement. Among reproducibility measures available to assess clinical and epidemiological methods of dental caries, the overall percentage of agreement, Kappa statistic, Dice coefficient, and intraclass correlation coefficient (ICC) are highlighted, since they are generally extremely important instruments to verify and improve research accuracy. Final Considerations: The appropriate and recommended use of reliability instruments is of major importance, because it generates answers and guidance regarding the ability and accuracy of the instrument or method used.

Keywords: Diagnosis. Reproducibility of tests. Validity of tests.

Introdução

O termo reprodutibilidade (confiabilidade, fidedignidade, repetibilidade ou precisão; em inglês: reproducibility, reliability, repeatability, consistency, stability, precision) pode ser definido como o grau de consistência ou de concordância dos resultados quando a medição ou o exame se repete, em condições idênticas1. A confiabilidade não constitui atributo do desenho da investigação como um todo, mas, sim, uma qualidade exclusiva dos instrumentos de coleta de dados2.

Em estudos epidemiológicos, a precisão dos métodos de aferição das variáveis de estudo é fundamental para demonstrar que a medida de aferição utilizada é capaz de avaliar o que foi planejado. Nesse sentido, a estimação da confiabilidade torna-se um dos passos fundamentais. Essa estimação pode ser feita por meio de um conjunto de técnicas que refletem a quantidade de "erro" aleatório ou sistemático, inerente ao processo de aferição3.

Outro fator importante a se considerar no que diz respeito à qualidade da informação, além da reprodutibilidade, é o conceito de validade, que, em suma, se refere ao grau em que o método de aferição é adequado para medir o verdadeiro valor daquilo que é medido, observado ou interpretado4. Sob esse aspecto, existe uma relação complexa entre reprodutibilidade e validade, na qual, por exemplo, um teste de baixa reprodutibilidade, consequentemente, acarreta baixa validade, enquanto que um teste de alta reprodutilidade não assegura alta validade4. Isso porque um método pode ser reproduzível, mas não pode ser capaz de discriminar corretamente as diversas situações que se encontram na prática. Portanto, a questão da validade sempre deve ser adequadamente avaliada, ao lado da reprodutibilidade, no sentido de avaliar a qualidade de um exame diagnóstico, por exemplo, e, consequentemente, da informação por ele produzida.

Há diversas maneiras de verificar a reprodutibilidade de resultados entre leituras de um mesmo evento e, assim, estimar o erro cometido na sua aferição. Um fator importante a ser considerado, objetivando-se a minimização de erros e o aumento da reprodutibilidade de um método, diz respeito ao processo de calibração que corresponderia ao meio pelo qual se busca treinar examinadores ou observadores a fim de se assegurar a uniformização na interpretação, compreensão e aplicação dos critérios de exame e, desse modo, minimizar as variações intra e interexaminadores5.

A Organização Mundial da Saúde (OMS) define calibração como a repetição de exames nas mesmas pessoas pelos mesmos avaliadores ou pelo mesmo examinador em tempos diferentes, a fim de diminuir as discrepâncias de interpretação nos diagnósticos. Assim, objetiva-se, principalmente, assegurar uniformidade de interpretação, de entendimento e de aplicação dos critérios das várias doenças e condições a serem observadas e registradas; garantir, também, que cada um dos examinadores possa trabalhar consistentemente com o padrão adotado e minimizar as variações entre diferentes avaliadores6.

Em estudos relacionados à odontologia, é observada a ausência de consistência diagnóstica e a falta de reprodutibilidade relacionada à análise de dados, que envolvem diagnósticos clínicos subjetivos. As pesquisas odontológicas clínicas ou epidemiológicas apresentam variações na interpretação do critério de diagnóstico. No entanto, mesmo com os mais detalhados critérios de diagnósticos, não se tem garantia da consistência do examinador, pois mesmo um único examinador pode ser inconsistente de uma ocasião para outra7.

Dessa forma, faz-se necessária a utilização de instrumentos estatísticos com a finalidade de verificar a confiabilidade dos métodos utilizados no estudo, por meio do cálculo do nível de concordância, visando ao aumento da precisão da pesquisa. Dentre os principais testes descritos para se verificar o nível de concordância, destacam-se a porcentagem geral de concordância, a estatística Kappa, o índice Dice e o coeficiente de correlação intraclasse, os quais serão descritos em maior detalhamento a seguir.

Assim, o objetivo do presente trabalho foi fazer uma revisão sobre reprodutibilidade dos métodos e os instrumentos estatísticos utilizados nos estudos, a fim de obter informações importantes para uma melhor evidência científica.

Revisão de literatura

Coeficientes e estatísticas utilizadas para avaliação da reprodutibilidade

Porcentagem geral de concordância

A concordância percentual é a maneira mais natural de se dimensionar o grau de concordância entre as avaliações. Apesar da vantagem de sua simplicidade e facilidade de interpretação, a porcentagem geral de concordância tem basicamente duas desvantagens. A primeira diz respeito à sua dependência às frequências das categorias da variável. Por exemplo, quando a prevalência é baixa, o valor da concordância percentual tende a ser alto, mesmo que a concordância seja alta ou inexistente. Entretanto, uma alternativa para esse problema seria calcular a porcentagem geral de concordância apenas para os casos com ao menos uma avaliação positiva, o que também é conhecido como concordância de Chamberlain8.

A segunda limitação, que faz com que, praticamente, não se use a concordância percentual como o índice padrão de confiabilidade, se refere à sua falta de consideração das concordâncias que podem acontecer pelo acaso, ou seja, não considera que mesmo que as avaliações fossem completamente não relacionadas (de forma aleatória), essas poderiam, eventualmente, coincidir (positivo-positivo ou negativo-negativo) apenas pela chance9-11.

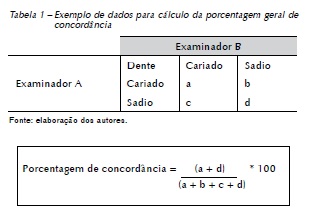

O cálculo de concordância é relativamente simples e é apresentado pelo exemplo a seguir (Tabela 1).

Estatística Kappa

A estatística Kappa é frequentemente utilizada para expressar concordância, sendo diferente de outros coeficientes de concordância por ser ajustada e levar em consideração outros fatores além da chance8.

O cálculo de Kappa é uma das principais estratégias utilizadas na literatura quando o interesse é a avaliação da concordância de uma medida categórica, sendo seu uso disseminado nos estudos de valida de e reprodutibilidade, sendo o cálculo do índice com potenciais erros de interpretação ou de mau uso12.

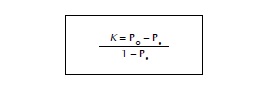

Em resumo, tem-se:

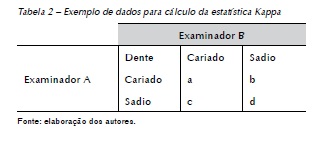

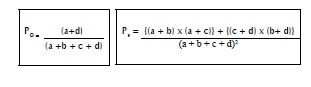

Em que, PO é a concordância observada e Pe é a concordância esperada pelo acaso. Os cálculos de PO e Pe são dados pelo exemplo a seguir (Tabela 2).

Em que:

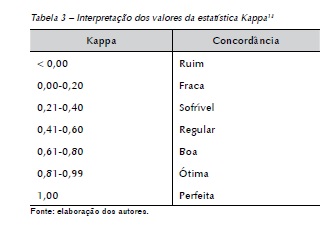

A interpretação dos resultados de Kappa informa a proporção de concordância, além da esperada pela chance, e varia de "menos 1" a "mais 1", significando completo desacordo e exato desacordo nas leituras, respectivamente. A interpretação dos valores é apresentada na Tabela 3.

O índice Kappa é, provavelmente, o mais confiável meio de se avaliar a concordância total do examinador4. Entretanto, pela sua natureza dicotômica, o índice Kappa não avalia adequadamente a reprodutibilidade em metodologias que envolvem múltiplos critérios. O Kappa de Cohen pode levar a conclusões indevidas, pois discordâncias de escores intra e interexaminador são consideradas concordâncias, o que implica na sobrestimação dos valores de reprodutibilidade14.

Vale ressaltar que a interpretação das informações fornecidas pela estatística Kappa deve levar em conta alguns aspectos para que seja realizada uma verificação adequada e aprofundada dos resultados de concordância entre as observações ou avaliações4. Por exemplo, valores de Kappa podem ser mais baixos para populações nas quais a prevalência de cárie é mais alta, uma vez que o número de lesões de cárie estaria mais prevalente que em grupos nos quais há maior prevalência de dentes hígidos. Logo, mesmo que um valor de Kappa, eventualmente, seja considerado muito bom, não necessariamente implica em uma boa reprodutibilidade. Primeiro porque a estatística Kappa depende da prevalência, sendo útil para a análise da concordância de uma determinada situação em particular e não para comparações ou extrapolações para outras populações. Além disso, nos estudos interobservadores, é possível algum viés representado, por exemplo, por uma tendência de um avaliador em fornecer mais resultados positivos que outro14.

No caso de se calcular o Kappa quando a variável sob avaliação é ordinal, uma modificação do índice foi proposta, uma vez que o cálculo do Kappa simples não leva em consideração a falta de homogeneidade entre os casos discordantes, o que seria natural se a variável fosse nominal. Portanto, propõe-se que a modificação seja aplicada em estudos que envolvam diferentes graus de severidade da doença, a fim de ajustar o grau de concordância dos dados pela gravidade dos casos discordantes, a partir do estabelecimento de pesos (variando de 0 a 1), gerando a estatística conhecida como Kappa ponderado14. A diferença básica do Kappa ponderado para o Kappa simples é que, para a obtenção daquelas concordâncias observadas e esperadas pelo acaso (C e C0), são considerados pesos atribuídos a cada célula da tabela de concordância, aplicados previamente aos dados observados e aos dados esperados. Dessa forma, poderia ser obtida uma maior quantidade de informações sobre a reprodutibilidade dos examinadores.

Índice Dice

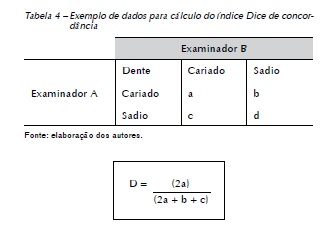

O índice Dice é uma medida de similaridade sobre conjuntos. Esse índice é uma alternativa ao Kappa para o caso em que apenas uma classe se constitui objeto de interesse, como, por exemplo, o número de dentes cariados.

Esse índice apresenta a vantagem de que sua concordância é de fácil aplicação10, fornecendo com rapidez uma avaliação comparativa razoavelmente adequada, além de permitir o cálculo manual, enquanto que a estatística Kappa, geralmente, requer recursos de computação. Seu cálculo leva em consideração o peso médio de dois componentes, como pode ser visto no exemplo a seguir (Tabela 4).

Entretanto, ressalta-se que, apesar da facilidade de execução do cálculo, esse índice tem sido preconizado e empregado em poucas pesquisas epidemiológicas, devido ao fato de o índice levar em consideração apenas os resultados de concordância e discordância entre os examinadores com relação aos casos positivos, ou seja, de doença. Nesse sentido, a estatística Kappa tem sido mais preconizada por ser uma medida mais abrangente.

Coeficiente de correlação intraclasse

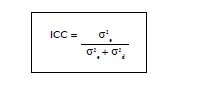

O coeficiente de correlação intraclasse (Intraclass correlation coefficient – ICC) é uma das ferramentas estatísticas mais utilizadas para a mensuração da confiabilidade de medidas. O ICC é adequado para mensurar a homogeneidade de duas ou mais medidas e é interpretado como a proporção da variabilidade total atribuída ao objeto medido15.

Esse coeficiente também é recomendado para avaliar a concordância entre examinadores quando a variável investigada for quantitativa ou numérica, pois avalia o grau de concordância desconsiderando aquela obtida além das chances, ou seja, a concordância atribuída ao acaso16.

Em termos conceituais, a expressão mais simples para o cálculo do ICC é dada por:

Em que o cálculo do ICC corresponde à soma das distâncias quadráticas de todas as observações em relação à média que se relaciona ao conceito de variância, ou seja, ao quadrado do desvio padrão (σ2). Essa variabilidade total é decomposta em duas partes (σ2 e e σ2 d), a variabilidade inter (σ2 e) e a variabilidade intra (σ2 d), que avalia o erro da medida.

Basicamente, pode-se perceber que quando não há erro de medida, por exemplo, quando todas as medidas para o mesmo paciente são iguais, tem-se σ2 d = 0, portanto, ICC = 1. De outro modo, quando não há variabilidade entre os pacientes (σ2 e = 0), por exemplo, qualquer variabilidade nos dados será por conta do erro de medida, tem-se então um ICC = 017.

O cálculo do coeficiente de correlação intraclasse é, do ponto de vista estatístico, adequado para estudos de concordância de uma variável numérica. Entretanto, suas diversas variantes e dificuldades operacionais de estimação, além da falta de interpretação clínica imediata para o valor estimado, podem desestimular seu uso. O ICC é mais uma medida de concordância e, dadas as suas limitações, propõe, adicionalmente, o uso de testes estatísticos, tal como o teste t pareado17.

Discussão

Reprodutibilidade dos métodos clínicos e epidemiológicos para diagnóstico da cárie

Diante da necessidade de utilizar e produzir a melhor evidência científica disponível, seria importante que todos os aspectos metodológicos para melhorar a qualidade dos estudos em geral fossem levados em consideração, dentre eles, aqueles que dizem respeito à concordância e à capacidade de reprodutibilidade dos métodos18.

Todavia, nem sempre é obtido em pesquisas clínicas e epidemiológicas, o nível de reprodutibilidade encontrado em investigações de laboratório, visto que o processo de diagnóstico é repleto de subjetividades e, por isso, suscetível a interpretações discordantes. Nesse sentido, os processos de calibração e sistematização da coleta de dados, com passos definidos e ordenados de conduta, tenderiam a melhorar a qualidade da informação e, consequentemente, a concordância entre os examinadores que utilizam tal procedimento5.

Sob esse aspecto, o preconizado para a obtenção da melhor precisão nos estudos de diagnóstico da cárie dentária seria um período de treinamento e de definição dos procedimentos a serem realizados previamente ao início do estudo. Em seguida, seriam realizados procedimentos de tentativa de uniformização de critérios intra e interexaminadores por meio da calibragem, objetivando-se eliminar ou minimizar as discordâncias de modo a selecionar os profissionais que consigam reproduzir de maneira estatisticamente confiável os critérios estabelecidos para os métodos adotados no estudo19.

Em um estudo no qual foi investigada a influência de diferentes ambientes (epidemiológico e clínico) e diferentes limiares de diagnóstico para detecção da cárie dentária, um criterioso processo de calibração dos examinadores foi realizado. A calibração incluir treinamentos e exercícios em ambos os ambientes, com realização de discussão teórica e uso de fotografias clínicas previamente às sessões clínicas de treinamento e calibração20. Em relação às sessões de treinamento clínico, foram realizados quatro períodos separados (4 horas cada), seguido por um exercício de calibração para garantir que todos os examinadores estivessem realizando os exames sob os mesmos padrões. A concordância interexaminadores encontrada foi considerada ótima, de acordo com a interpretação dos valores de Kappa (0,88 para o índice OMS+LI e 0,95 para o índice OMS no diagnóstico da cárie sob condições epidemiológicas; 0,90 para o índice OMS+LI em um ambiente tradicional clínico), demonstrando a importância do minucioso planejamento dos critérios de calibração a serem realizados para a melhoria da precisão dos resultados20.

Em termos empíricos, particularmente em relação aos instrumentos epidemiológicos, a precisão é avaliada pelos diversos indicadores de confiabilidade descritos na literatura científica. Buscando a comparação entre medidas de reprodutibilidade para a calibração em levantamentos epidemiológicos de cárie dentária, a porcentagem geral de concordância, o índice Dice e a estatística Kappa foram comparados11 sob diferentes níveis de detecção da doença. Foram encontrados valores altos para os índices Kappa, porcentagem geral de concordância e Dice (> 0,90), com a exceção do índice Dice para o limiar de diagnóstico OMS+LI. Essa excessão ocorreu devido ao fato de esse instrumento enfatizar a presença da doença e, ainda, devido à dificuldade de diagnóstico das lesões iniciais de cárie, o que gera maior discordância entre os examinadores. Em relação às medidas de reprodutibilidade, os autores concluíram que o índice Kappa seria mais adequado para cálculo da reprodutibilidade intra e interexaminador durante a calibração da cárie dentária por ser um índice de concordância ajustado. Todavia, na impossibilidade de seu uso, seria recomendada a utilização da porcentagem geral de concordância associada, posteriormente ao índice Dice.

Portanto, tendo por base o exposto, a correta utilização de alguns princípios qualifica um estudo e possibilita uma melhor consistência de seus achados. Como no caso do desenvolvimento de novos sistemas de critério de diagnóstico para a cárie dentária21-23, em que a definição de critérios adequados, o treinamento e a determinação da reprodutibilidade previamente definida no início do estudo e o controle da reprodutibilidade durante o período experimental permitiram o desenvolvimento de critérios válidos e precisos para a aplicação clínica e o desenvolvimento de novos estudos.

Adicionalmente, a verificação do grau de confiabilidade de novas tecnologias desenvolvidas com o intuito de auxiliar os sistemas de diagnósticos tradicionais de cárie dentária (inspeção visual e radiografia), ou sua comparação com os sistemas tradicionais, deve ser, e tem sido realizada, haja vista a importância de se obter resultados precisos, considerando- se a influência decisiva de tais estudos na capacidade de gerar evidência científica24-23.

Considerações finais

Em suma, é importante considerar que a precisão obtida em estudos apresenta estreita relação com o conhecimento e a utilização de aspectos metodológicos adequados. Dessa forma, deve-se buscar a crescente melhoria na qualidade e confiabilidade dos estudos, pelo emprego de instrumentos de medida de acordo não só com a confiança inerente a esses, mas de acordo com o tipo de pesquisa, com a prevalência da doença, com o grau de precisão pretendido e com os recursos disponíveis para a realização dessa; buscando-se sempre um adequado treinamento, um certo controle e uma determinação da reprodutibilidade.

Referências

1. Booth ML, Okely AD, Chey TM, Bauman A. The reliability and validity of the Adolescent Physical Activity Recall Questionnaire. Med Sci Sports Exerc 2002; 34:1986-95. [ Links ]

2. Almeida Filho N, Rouquayrol MZ. Diagnóstico em epidemiologia. In: Rouquayrol MZ, Almeida Filho N. Introdução à epidemiologia. 3. ed. Rio de Janeiro: MEDSI; 2002. p. 79-98.

3. Góes PSA, Fernandes LMA, Lucena LBS. Validação de instrumentos de coleta de dados. In: Antunes JLF, Peres MA. Epidemiologia da saúde bucal. Rio de Janeiro: Guanabara Koogan; 2006. p. 390-7.

4. Pereira MG. Aferição dos eventos. In: Pereira MG. Epidemiologia: teoria e prática. Rio de Janeiro: Guanabara-Koogan; 1995. p. 358-76. 90.

5. Pereira AC. Normas operacionais para execução de levantamentos em odontologia. In: Pereira AC. Odontologia em saúde coletiva: planejando ações e promovendo saúde. Porto Alegre: Artmed; 2003. p. 83-116.

6. WHO – World Health Organization. Benefits for detecting caries in primary teeth. Caries Res 2012; 16(46):536-43.

7. Bulman JS, Osborn JF. Measuring diagnostic consistency. Br Dent J 1989; 166:377-81.

8. Pereira AC, Silva RP. Levantamentos epidemiológicos em Odontologia. In: Pereira AC. Tratado de saúde coletiva. Nova Odessa: Napoleão; 2009. p. 281-314.

9. Nuttall NM, Paul JW. The analysis of inter-dentist agreement in caries prevalence studies. Community Dent Health 1985; 2:123-8.

10. Pinto VG. Identificação de problemas. In: Pinto VG. Saúde bucal coletiva. 4. ed. Santos: Editora Santos; 2000. p. 139- 217.

11. Assaf AV, Zanin L, Meneghim MC, Pereira AC, Ambrosano GMB. Comparação entre medidas de reprodutibilidade para a calibração em levantamentos epidemiológicos da cárie dentária. Cad Saúde Pública 2006; 22(9):1901-7.

12. Maclure M, Willet WC. Misinterpretation and misuse of the kappa statistics. American Journal Epidemiol 1987; 2:161-9.

13. Landis RJ, Koch GG. The measurement of observer agreement for categorical data. Biometrics 1977; 33:159-74.

14. Bulman JS, Osborn JF. Measuring diagnostic consistency. Br Dent J 1989; 166:377-81.

15. Shrout PE, Fleiss JL. Intraclass correlations: uses in assessing reliability. Psychol Bull 1979; 2:420-8.

16. Bartko JJ, Carpenter WT. On the methods and theory of reliability. J Nerv Ment Dis 1976; 163:307-17.

17. Barkto JJ. General methodology II – measures of agreement: a single procedure. Stat Med 1994; 13:737-45.

18. Richards D, Lawrence A. Evidence based dentistry. Br Dent J 1995; 179(7):75-82.

19. Peres MA, Traebert J, Marcenes W. Calibração de examinadores para estudos epidemiológicos de cárie dentária. Cad Saúde Pública 2001; 17:153-9.

20. Kassawara ABC, Assaf AV, Meneghim MC, Pereira AC, Topping G, Levin K, et al. Comparison of epidemiological evaluations under different caries diagnostic thresholds. Oral Health Prev Dent 2007; 2:137-44.

21. Nyvad B, Machiulskiene V, Baelum V. Reliability of a new caries diagnostic system differentiating between active and inactive caries lesions. Caries Res 1999; 33:252-60.

22. Nyvad B, Machiulskiene V, Baelum V. Construct and predictive validity of clinical caries diagnostic criteria assessing lesion activity. J Dent Res 2003; 82:117-22.

23. Ismail AI, Sohn W, Tellez M, Amaya A, Sen A, Hasson H, et al. The International Caries Detection and Assessment System (ICDAS): an integrated system for measuring dental caries. Community Dent Oral Epidemiol 2007; 35:170-8.

24. Ekstrand KR, Martignon S, Ricketts DJ, Qvist V. Detection and activity assessment of primary coronal caries lesions: a methodologic study. Oper Dent 2007; 32:225-35.

25. Lussi A, Imwinkelried S, Pitts N, Longbottom C, Reich E. Performance and reproducibility of a laser fluorescence system for detection of occlusal caries in vitro. Caries Res 1999; 33:261-6.

26. da Silva RP, Assaf AV, Pereira SM, Ambrosano GM, Mialhe FL, Pereira AC. Reproducibility of adjunct techniques for diagnosis of dental caries in an epidemiological situation. Oral Health Prev Dent 2011; 9:251-9.

27. Pereira AC, Eggertsson H, González-Cabezas C, Zero DT, Eckert GJ, Mialhe FL. Quantitative light-induced in relation to other technologies and conventional methods for detecting occlusal caries in permanent teeth. Braz J Oral Sci 2011; 10:27-32.

28. Mendes FM, Novaes TF, Matos R, Bittar DG, Piovesan C, Gimenez T, et al. Radiographic and laser fluorescence methods have no benefits for detecting caries in primary teeth. Caries Res 2012; 16(46):536-43.

Endereço para correspondência:

Endereço para correspondência:

Marilia Mattar de Amoêdo Campos Velo

Al. Octávio Pinheiro Brisola, 9-75- FOB/USP

17012901 Bauru, SP

e-mail: mariliavelo@yahoo.com.br

Recebido: 19/10/14

Aceito: 23/03/16